在听取了别人的建议后,他打开了首都之窗网站的主页,在“奥运场馆”服务的列表下找到了这样一个栏目:《中国手语奥运常用语》。安装好插件后,他即刻进入了中国手语奥运会常用语教学频道的界面:轻点鼠标,一位身穿中国红颜色外套的三维虚拟人就会适时地将“奥林匹克”、“残奥会”,以及“欢迎光临!”、“您想吃什么?”等常用词汇和句子演示为标准手语。

小张很高兴,有这样的老师帮助学习,自己一定能够顺畅地和聋哑朋友们交流。

历时八年的成果

或许很多人还不知道,为中国手语奥运会常用语教学提供技术支持的是中国科学院计算技术研究所的研究人员。该所的手语识别与合成课题组历时8年,开发出了先进的手语识别与合成技术。

“顾名思义,手语识别与合成技术包括手语识别和手语合成两部分。”参与该课题研究的中国科学院计算技术研究所普适计算研究中心常务副主任陈益强说

所谓“手语识别”,是指通过计算机采集设备获得聋哑人的手语数据,采用模式识别算法,结合上下文知识,获知手语含义,进而翻译成语音,传达给不懂手语的正常人。这样,正常人就可以“听懂手语”。而“手语合成”则是指正常人通过语音表达自己的意图,计算机将语音翻译为手语并表现出来,向聋哑人传递信息。这样,聋哑人就能够“看懂声音”。

据了解,我国听力、语言残障人士超过2000万人,而且每年还在以2万~3万名的速度递增。对手语——这类人群最重要的交际手段——进行研究,不仅有助于改善和提高这些残疾人士的生活、学习和工作条件,为他们提供更好的服务,同时也可以应用于计算机辅助哑语教学、电视节目双语播放、虚拟人研究、电影制作中的特技处理、动画制作、医疗研究、游戏娱乐等诸多方面。

北京电视台的《新闻手语》栏目创办于1989年,是在国内最早推出的一档手语节目,曾引领全国电视公益事业先河。2007年1月1日开始,《新闻手语》在北京卫视的播出时间由每日5分钟延长为8分钟,并在全国第一次启用数字模拟机器人打手语,手语播报更加标准化、程序化。“为它们提供技术支持的就是我们。”陈益强自豪地告诉记者。

据记者了解,此前电视台在播放手语新闻时,都是由一名手语翻译员来完成这一工作。不过,在中科院计算技术研究所研制的电视台用手语电视节目制作系统的帮助下,新闻文本已经可以通过计算机自动合成手语视频窗口,与电视节目同步播放。

在2008年北京奥运会和残奥会举办过程中,由该所研制的奥运新闻实时播报系统也得到了展示,对奥运志愿者进行培训的奥运手语在线互动教学系统更是获得了北京市信息办和残联等各部门的支持,成为2008年残奥会志愿者必备的学习软件。

攻克五大难关

“尽管‘手语识别与合成’技术的出现,使得聋哑人与健听人之间的‘对话’成为可能,但要完全实现‘听懂手语,看懂声音’的目标还需要解决很多技术难点。”陈益强说。

据了解,这些难点主要包括手语运动数据获取不完整、多维手语运动数据识别、大词汇量识别、非特定人的识别、手语多模态表达的复杂性及手语运动数据的重定向等。为了解决这些难题,从2000年到现在,中科院计算所手语识别与合成项目组一直在着力攻克五大难关,并在此过程中研发出了大量核心技术,申请国家发明专利20余项,其中手语编辑、手语翻译等相关专利已获授权。

“这五大难关主要包括数据采集和处理、大词汇量手语识别、非特定人手语识别、手语多模态表达以及手语运动数据重定向。”陈益强说。

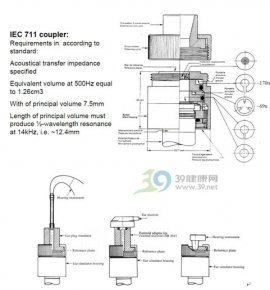

据介绍,手语识别系统主要分为基于数据手套的识别和基于视觉(图像)的手语识别系统。基于数据手套的手语识别系统,是利用数据手套和位置跟踪器测量手势在空间运动的轨迹和时序信息。这种方法的优点是系统的识别率高,缺点是打手语的人要穿戴复杂的数据手套和位置跟踪器,并且输入设备比较昂贵。不过,由于摄像头在将三维立体的手语数据转为平面二维数据时会丢失很多数据信息,而数据手套获取三维数据信息的效果很好,因此手语识别与合成课题组决定主要以数据手套的方式采集数据。

“我们使用了2只数据手套和3个六自由度位置跟踪器,基于运动跟踪的原理,记录真实人体演示每个手语词的运动数据,以建立初始的手语词运动数据库。然后,再对每个手语词的运动数据进行编辑与微调,最后得到高质量的手语词运动数据库。”陈益强告诉记者。

据了解,在10多位聋校老师和很多聋校学生的帮助下,手语识别与合成课题组已建立了中国最大的手语词汇库,共有5500个词,并采用手语词根建模的识别方式来解决大词汇量的识别问题。这已经走在了国际前列。

与实用的距离

“目前手语识别与合成技术与实用还有一定距离。”陈益强毫不讳言。

据介绍,建立非特定人的识别模式是手语识别技术走向实用的关键。然而,非特定人手语识别因为需要训练库包含更多人的手语样本,其数据多且差异大的特点导致模型训练难以集中。此外,从不同人的数据中提取有效的共同特征也较为困难。

为此,手语识别与合成课题组采用了“自组织特征映射/隐马尔可夫模型”(SOFM/HMM)相结合的模型。实验结果表明,该模型比传统的HMM模型识别率提高近5%,较好地解决了非特定人识别问题。

此外,残疾人之间互相交流时,不仅看手的动作,还要通过表情和唇动等方式传递丰富的辅助信息。手语识别与合成课题组由此提出利用大量真实多模式行为数据进行学习训练,获取单模式行为的韵律模型以及多模式行为之间的协同关联模型,从而实现虚拟人多模式行为之间的协同。

陈益强透露,在聋校的测试实验表明,经过多模式行为协同而合成的连续手语,其可懂度达到94.6%,比没有多模式协同的手语可懂度提高近6%。

即便如此,让陈益强遗憾的是,手语识别与合成技术目前仍在理解自然手语方面存在一定困难。他希望未来能通过与从事机器翻译研究的人士合作越过这一障碍。

据悉,除此之外,手语识别与合成课题组还确立了新的目标框架。他们一方面要将手语技术继续整合于功能日益强大的个人助理终端,完善软件功能;一方面则想基于计算技术领域最新成果,为用户提供新颖和更加人性化、个性化的服务。如利用无线定位技术和行为识别技术,实时感知聋哑人所处位置和状态,向用户或监护人提供及时的视频播放服务或监护提示服务等。